Google Bard AI – از چه سایت هایی برای آموزش آن استفاده شده است؟

Google’s Bard بر اساس مدل زبان LaMDA است که بر روی مجموعه دادههای مبتنی بر محتوای اینترنتی به نام Infiniset آموزش داده شده است که اطلاعات بسیار کمی در مورد اینکه دادهها از کجا آمدهاند و چگونه آنها را دریافت کردهاند.

مقاله تحقیقاتی LaMDA 2022 درصدی از انواع مختلف داده های مورد استفاده برای آموزش LaMDA را فهرست می کند، اما تنها 12.5٪ از مجموعه داده های عمومی از محتوای خزیده شده از وب و 12.5٪ دیگر از ویکی پدیا می آید.

گوگل عمداً مبهم است که بقیه دادههای خراششده از کجا آمدهاند، اما نکاتی درباره اینکه چه سایتهایی در آن مجموعه دادهها هستند وجود دارد.

مجموعه داده Infiniset گوگل

Google Bard بر اساس یک مدل زبان به نام LaMDA است که مخفف آن است مدل زبان برای کاربردهای گفتگو.

LaMDA بر روی مجموعه داده ای به نام Infiniset آموزش داده شد.

Infiniset ترکیبی از محتوای اینترنتی است که عمداً برای افزایش توانایی مدل برای درگیر شدن در گفتگو انتخاب شده است.

مقاله تحقیقاتی LaMDA (PDF) توضیح می دهد که چرا آنها این ترکیب محتوا را انتخاب کردند:

این ترکیب برای دستیابی به عملکرد قوی تری در وظایف محاوره ای انتخاب شد … در حالی که هنوز توانایی خود را برای انجام سایر وظایف مانند تولید کد حفظ می کند.

به عنوان کار آینده، ما می توانیم بررسی کنیم که چگونه انتخاب این ترکیب ممکن است بر کیفیت برخی از وظایف NLP دیگر انجام شده توسط مدل تأثیر بگذارد.

مقاله پژوهشی به گفتگو و دیالوگ ها، که املای کلمات استفاده شده در این زمینه، در حوزه علوم کامپیوتر است.

در مجموع، LaMDA روی 1.56 تریلیون کلمه از قبل آموزش داده شده بود.داده های گفتگوی عمومی و متن وب“

مجموعه داده از ترکیب زیر تشکیل شده است:

- 12.5 درصد داده های مبتنی بر C4

- 12.5% ویکی پدیای انگلیسی زبان

- 12.5٪ اسناد کد از وب سایت های برنامه نویسی پرسش و پاسخ، آموزش ها و موارد دیگر

- 6.25٪ اسناد وب انگلیسی

- 6.25٪ اسناد وب غیر انگلیسی

- 50٪ داده ها را از انجمن های عمومی باز می کند

دو بخش اول Infiniset (C4 و Wikipedia) از داده هایی تشکیل شده است که شناخته شده است.

مجموعه داده C4، که به زودی مورد بررسی قرار خواهد گرفت، یک نسخه فیلتر شده ویژه از مجموعه داده Common Crawl است.

تنها 25 درصد از داده ها از یک منبع نامگذاری شده است C4 مجموعه داده و ویکیپدیا).

بقیه دادههایی که 75 درصد از مجموعه دادههای Infiniset را تشکیل میدهند، شامل کلماتی است که از اینترنت حذف شدهاند.

مقاله تحقیقاتی نمیگوید چگونه دادهها از وبسایتها، از چه وبسایتهایی یا جزئیات دیگری در مورد محتوای خراششده بهدست آمده است.

Google فقط از توضیحات کلی مانند “اسناد وب غیر انگلیسی” استفاده می کند.

لغت کدر به معنای زمانی است که چیزی توضیح داده نمی شود و بیشتر پنهان است.

Murky بهترین کلمه برای توصیف 75 درصد از داده هایی است که گوگل برای آموزش LaMDA استفاده کرده است.

سرنخ هایی وجود دارد که ممکن است یک ایده کلی ارائه دهد از چه سایت هایی در 75 درصد محتوای وب موجود است، اما ما نمی توانیم به طور قطع بدانیم.

مجموعه داده C4

C4 مجموعه داده ای است که توسط گوگل در سال 2020 توسعه یافته است. C4 مخفف “غول پیکر پاک Crawled Corpus“

این مجموعه داده بر اساس داده های Common Crawl است که یک مجموعه داده منبع باز است.

درباره Common Crawl

Common Crawl یک سازمان غیرانتفاعی ثبت شده است که به صورت ماهانه در اینترنت می خزند تا مجموعه داده های رایگان ایجاد کند که هر کسی بتواند از آن استفاده کند.

سازمان Common Crawl در حال حاضر توسط افرادی اداره میشود که برای بنیاد ویکیمدیا کار کردهاند، Googlerهای سابق، بنیانگذار Blekko، و افرادی مانند پیتر نورویگ، مدیر تحقیقات گوگل و دنی سالیوان (همچنین از گوگل) به عنوان مشاور به حساب میآیند.

چگونه C4 از Common Crawl توسعه یافته است

دادههای خام Common Crawl با حذف مواردی مانند محتوای نازک، کلمات زشت، lorem ipsum، منوهای ناوبری، کپیبرداری و غیره پاک میشوند تا مجموعه داده به محتوای اصلی محدود شود.

هدف از فیلتر کردن دادههای غیرضروری حذف ابهامات و حفظ نمونههای انگلیسی طبیعی بود.

این همان چیزی است که محققان سازنده C4 نوشتند:

«برای جمعآوری مجموعه دادههای پایه خود، متن استخراجشده وب را از آوریل ۲۰۱۹ دانلود کردیم و فیلتر فوقالذکر را اعمال کردیم.

این مجموعهای از متن را تولید میکند که نه تنها مرتبهای بزرگتر از بسیاری از مجموعههای دادهای که برای پیشآموزش استفاده میشوند (حدود ۷۵۰ گیگابایت) است، بلکه شامل متن انگلیسی نسبتاً تمیز و طبیعی است.

ما این مجموعه داده را “Colossal Clean Crawled Corpus” (یا به اختصار C4) دوبله می کنیم و آن را به عنوان بخشی از TensorFlow Datasets منتشر می کنیم.

نسخه های فیلتر نشده دیگری از C4 نیز وجود دارد.

مقاله تحقیقاتی که مجموعه داده های C4 را توصیف می کند، با عنوان “کاوش در محدودیت های یادگیری انتقال با یک تبدیل کننده متن به متن یکپارچه” (PDF) است.

یک مقاله تحقیقاتی دیگر از سال 2021، (مستند کردن مجموعه های متنی بزرگ وب: مطالعه موردی در مجموعه عظیم Clean Crawled Corpus – PDF) ساختار سایت های موجود در مجموعه داده C4 را بررسی کرد.

جالب اینجاست که دومین مقاله تحقیقاتی ناهنجاریهایی را در مجموعه دادههای اصلی C4 کشف کرد که منجر به حذف صفحات وبی که همتراز با اسپانیایی تبار و آفریقاییتبار بودند، شد.

صفحات وب همتراز شده با زبان اسپانیایی توسط فیلتر لیست بلاک (کلمات فحش و غیره) به میزان 32 درصد از صفحات حذف شدند.

صفحات وب تراز شده آفریقایی آمریکایی با نرخ 42 درصد حذف شدند.

احتمالاً این کاستی ها برطرف شده است…

یافته دیگر این بود که 51.3 درصد از مجموعه داده C4 شامل صفحات وب است که در ایالات متحده میزبانی می شدند.

در نهایت، تجزیه و تحلیل سال 2021 مجموعه داده اصلی C4 تأیید می کند که مجموعه داده تنها کسری از کل اینترنت را نشان می دهد.

در تحلیل آمده است:

«تحلیل ما نشان میدهد که در حالی که این مجموعه داده بخش قابل توجهی از اینترنت عمومی را نشان میدهد، به هیچ وجه نماینده دنیای انگلیسی زبان نیست و طیف وسیعی از سالها را در بر میگیرد.

هنگام ساخت یک مجموعه داده از یک خراش وب، گزارش دامنههایی که متن از آنها خراشیده میشود برای درک مجموعه داده ضروری است. فرآیند جمعآوری دادهها میتواند منجر به توزیع بسیار متفاوت دامنههای اینترنتی با آنچه که انتظار میرود، شود.»

آمار زیر در مورد مجموعه داده C4 از دومین مقاله تحقیقاتی است که در بالا پیوند داده شده است.

25 وب سایت برتر (براساس تعداد توکن ها) در C4 عبارتند از:

- patents.google.com

- en.wikipedia.org

- en.m.wikipedia.org

- www.nytimes.com

- www.latimes.com

- www.theguardian.com

- journals.plos.org

- www.forbes.com

- www.huffpost.com

- Patents.com

- www.scribd.com

- www.washingtonpost.com

- www.fool.com

- ipfs.io

- www.frontiersin.org

- www.businessinsider.com

- www.chicagotribune.com

- www.booking.com

- www.theatlantic.com

- link.springer.com

- www.aljazeera.com

- www.kickstarter.com

- caselaw.findlaw.com

- www.ncbi.nlm.nih.gov

- www.npr.org

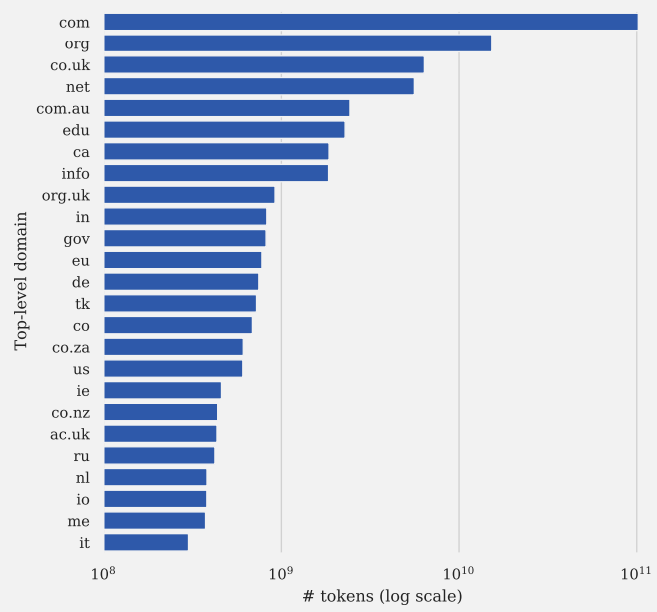

اینها 25 دامنه برتر سطح بالا در مجموعه داده C4 هستند:

اسکرین شات از مستندسازی مجموعههای متنی وب بزرگ: مطالعه موردی در مجموعه عظیم خزنده پاک

اسکرین شات از مستندسازی مجموعههای متنی وب بزرگ: مطالعه موردی در مجموعه عظیم خزنده پاکاگر علاقه مند به کسب اطلاعات بیشتر در مورد مجموعه داده C4 هستید، توصیه میکنم مستندسازی لارج Webtext Corpora: یک مطالعه موردی در مجموعه عظیم Clean Crawled Corpus (PDF) و همچنین مقاله تحقیقاتی اصلی 2020 (PDF) که C4 برای آن ایجاد شده است را مطالعه کنید.

دادههای دیالوگ از انجمنهای عمومی چه میتواند باشد؟

50 درصد از داده های آموزشی از “دیالوگ های داده ها از انجمن های عمومی“

این تمام چیزی است که مقاله تحقیقاتی LaMDA گوگل در مورد این داده های آموزشی می گوید.

اگر بخواهیم حدس بزنیم، Reddit و دیگر جوامع برتر مانند StackOverflow شرطبندی مطمئنی هستند.

Reddit در بسیاری از مجموعه دادههای مهم مانند مجموعههای توسعهیافته توسط OpenAI به نام WebText2 (PDF)، تقریبی منبع باز از WebText2 به نام OpenWebText2 و مجموعه دادههای WebText مانند (PDF) خود گوگل از سال 2020 استفاده میشود.

گوگل همچنین یک ماه قبل از انتشار مقاله LaMDA جزئیات دیگری از مجموعه داده های سایت های گفتگوی عمومی را منتشر کرد.

این مجموعه داده که حاوی سایت های گفتگوی عمومی است MassiveWeb نامیده می شود.

ما حدس نمی زنیم که مجموعه داده MassiveWeb برای آموزش LaMDA استفاده شده باشد.

اما این شامل یک مثال خوب از آنچه گوگل برای مدل زبان دیگری که بر دیالوگ متمرکز بود، انتخاب کرد.

MassiveWeb توسط DeepMind که متعلق به گوگل است ایجاد شده است.

این برای استفاده توسط یک مدل زبان بزرگ به نام Gopher (پیوند به PDF مقاله تحقیقاتی) طراحی شده است.

MassiveWeb از منابع وب محاوره ای که فراتر از Reddit هستند استفاده می کند تا از ایجاد سوگیری نسبت به داده های تحت تأثیر Reddit جلوگیری کند.

هنوز از Reddit استفاده می کند. اما همچنین حاوی داده هایی است که از بسیاری از سایت های دیگر خراشیده شده اند.

سایت های گفتگوی عمومی موجود در MassiveWeb عبارتند از:

- فیس بوک

- Quora

- یوتیوب

- متوسط

- سرریز پشته

باز هم، این نشان نمی دهد که LaMDA با سایت های فوق آموزش دیده است.

این فقط به این منظور است که نشان دهد گوگل چه چیزی را میتوانست استفاده کند، با نشان دادن مجموعه دادهای که گوگل روی آن تقریباً همزمان با LaMDA کار میکرد، مجموعهای که حاوی سایتهایی از نوع انجمن است.

37.5٪ باقی مانده

آخرین گروه از منابع داده عبارتند از:

- 12.5٪ اسناد کد از سایت های مرتبط با برنامه نویسی مانند سایت های پرسش و پاسخ، آموزش و غیره.

- 12.5% ویکی پدیا (انگلیسی)

- 6.25٪ اسناد وب انگلیسی

- 6.25٪ اسناد وب غیر انگلیسی.

گوگل مشخص نمی کند که چه سایت هایی در آن قرار دارند سایت های برنامه نویسی پرسش و پاسخ دسته ای که 12.5 درصد از مجموعه داده ای را تشکیل می دهد که LaMDA روی آن آموزش دیده است.

بنابراین ما فقط می توانیم حدس و گمان کنیم.

Stack Overflow و Reddit گزینههای واضحی به نظر میرسند، به خصوص که در مجموعه داده MassiveWeb گنجانده شدهاند.

چی “آموزش ها” سایت ها خزیده شدند؟ ما فقط می توانیم حدس بزنیم که آن سایت های “آموزش” ممکن است چه باشند.

این باعث می شود که سه دسته نهایی محتوا، که دو مورد از آنها بسیار مبهم هستند، باقی بماند.

ویکی پدیای انگلیسی نیازی به بحث ندارد، همه ما ویکی پدیا را می شناسیم.

اما دو مورد زیر توضیح داده نشده است:

انگلیسی و غیر انگلیسی صفحات وب زبان یک توصیف کلی از 13٪ از سایت های موجود در پایگاه داده است.

این تمام اطلاعاتی است که گوگل در مورد این بخش از داده های آموزشی می دهد.

آیا گوگل باید در مورد مجموعه داده های استفاده شده برای Bard شفاف باشد؟

برخی از ناشران از اینکه سایت هایشان برای آموزش سیستم های هوش مصنوعی استفاده می شود احساس ناراحتی می کنند زیرا به نظر آنها این سیستم ها در آینده می توانند وب سایت هایشان را منسوخ و ناپدید کنند.

اینکه آیا این درست است یا نه، باید دید، اما این یک نگرانی واقعی است که توسط ناشران و اعضای جامعه بازاریابی جستجو بیان شده است.

گوگل در مورد وبسایتهایی که برای آموزش LaMDA استفاده میشوند و همچنین فناوریهایی که برای خراش دادن وبسایتها برای یافتن دادهها استفاده شده است، بهطور ناامیدکنندهای مبهم است.

همانطور که در تجزیه و تحلیل مجموعه داده های C4 مشاهده شد، روش انتخاب محتوای وب سایت برای آموزش مدل های زبان بزرگ می تواند کیفیت مدل زبان را با حذف جمعیت های خاص تحت تاثیر قرار دهد.

آیا گوگل باید در مورد اینکه چه سایت هایی برای آموزش هوش مصنوعی خود استفاده می شود شفاف تر باشد یا حداقل یک گزارش شفاف سازی آسان در مورد داده های استفاده شده منتشر کند؟

تصویر برجسته توسط Shutterstock/Asier Romero