نمای کلی AI Glitch ممکن است به الگوریتم Google اشاره کند

جلوه های اجمالی AI Google ممکن است سهواً در معرض چگونگی درک الگوریتم Google ، نمایش داده های جستجو و انتخاب پاسخ ها را نشان دهد. اشکالات موجود در جستجوی گوگل برای بررسی مفید است زیرا ممکن است بخش هایی از الگوریتم های گوگل را که به طور معمول غیب هستند ، افشا کنند.

Ai-splaining؟

لیلی ری دوباره صدای جیر جیر را ارسال کرد که نشان داد چگونه تایپ عبارات مزخرف در گوگل منجر به پاسخ اشتباه می شود که در آن نمای کلی AI اساساً پاسخی را تشکیل می دهد. او آن را Ai-splaining نامید.

قهوه من را تف کنم.

من این را “جدا کردن ai” می نامم pic.twitter.com/k9tliwocqc

– لیلی ری 😏 (lilyraynyc) 20 آوریل 2025

کاربر Darth Autocrat (Lyndon NA) پاسخ داد:

“این نشان می دهد که چگونه G از” جستجو “شکسته است.

این “پیدا کردن مرتبط” یا “پیدا کردن مشابه” نیست ، به معنای واقعی کلمه چیزهایی را درست می کند ، به این معنی که G نیست

الف) موتور جستجو

ب) موتور پاسخ

ج) موتور توصیه ای که اکنون آنها هستند

د) یک شوخی بالقوه مضر “

Google سابقه طولانی در اشکالات جستجو دارد اما این متفاوت است زیرا پاسخ های خلاصه LLM بر اساس داده های زمینی (وب ، نمودار دانش و غیره) و خود LLM وجود دارد. بنابراین ، بازاریاب جستجو معروف به Darth Autocrat این نکته را دارد که این اشکال جستجوی Google در سطح کاملاً متفاوت از هر چیزی که قبلاً دیده شده است.

با این حال یک چیز وجود دارد که یکسان است و این این است که اشکالات جستجو فرصتی برای دیدن چیزی است که در پشت جعبه جستجو اتفاق می افتد که به طور معمول قابل مشاهده نیست.

اشکال AI محدود به Google AIO نیست

آنچه فکر می کنم اتفاق می افتد این است که سیستم های Google کلمات را تجزیه می کنند تا بدانند کاربر به چه معناست. بنابراین در موردی که پرس و جو کاربر مبهم باشد ، من فکر می کنم که LLM تصمیم می گیرد که کاربر بر اساس چندین معنی احتمالی ، مانند یک درخت تصمیم گیری در یادگیری ماشین ، که در آن یک دستگاه از معانی احتمالی استفاده می کند ، تصمیم می گیرد ، شاخه هایی را که حداقل به احتمال زیاد دارند حذف می کنند و معنای احتمالی را پیش بینی می کنند.

من در حال خواندن حق ثبت اختراع بودم که گوگل اخیراً در یک موضوع مرتبط قرار داده است ، جایی که یک هوش مصنوعی سعی می کند با هدایت کاربر از طریق یک درخت تصمیم گیری و سپس ذخیره آن اطلاعات برای تعامل های آینده با آنها یا دیگران ، حدس بزند که کاربر به چه معنی است. این ثبت اختراع ، نسل میکرو پروفیل در زمان واقعی با استفاده از ساختار درخت پویا ، برای دستیاران صوتی هوش مصنوعی است ، اما این ایده را ارائه می دهد که چگونه یک هوش مصنوعی سعی خواهد کرد حدس بزند که کاربر چه معنی دارد و سپس ادامه می یابد.

بنابراین من Google ، Chatgpt و Claude را آزمایش کردم و فهمیدم که هر سه اشتباه می کنند که به معنای پرس و جو کاربر به معنای استنباط می شوند و با اطمینان پاسخ اشتباه را ارائه می دهند.

سوال نمونه این بود:

تکنیک ماهیگیری توله سگ موازی برای باس راه راه چیست؟

هیچ چیز به عنوان “تکنیک ماهیگیری توله سگ موازی” وجود ندارد اما تکنیکی به نام “پیاده روی سگ” وجود دارد و تکنیک دیگری وجود دارد که یک ماهیگیر در کایاک یا یک قایق موازی با ساحل یا برخی از ساختار دیگر خواهد بود.

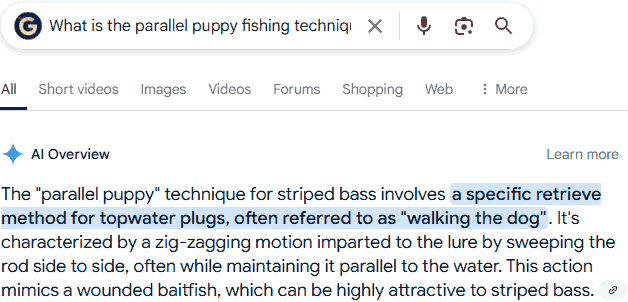

نمای کلی AI (AIO)

AIO با اطمینان پاسخ توهم را ارائه داد که نادرست است زیرا فرض می کرد کاربر چندین تاکتیک ماهیگیری واقعی را گیج می کند ، بنابراین تاکتیک های متعدد و فریب ماهیگیری را برای اختراع یک تاکتیک غیر موجود مخلوط می کند.

نمای کلی AI پاسخ اشتباه زیر را ارائه داد:

تکنیک “توله سگ موازی” برای باس راه راه شامل یک روش بازیابی خاص برای شاخه های آب بالا است ، که اغلب به آن “راه رفتن سگ” گفته می شود. این امر با یک حرکت زیگ زگینگ با جارو کردن میله به طرف ، غالباً در حالی که آن را به طور موازی با آب حفظ می کند ، مشخص می شود.

تصویر پاسخ توهم AIO

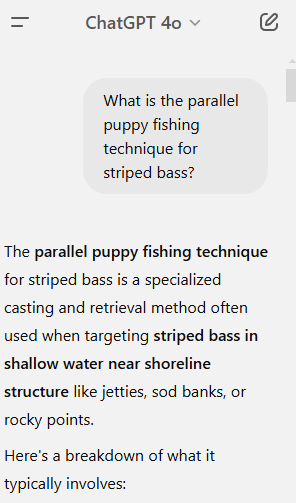

chatgpt 4o

Chatgpt همان اشتباهی را انجام داد که AIO Google انجام داد و یک تاکتیک پیچیده ماهیگیری را توهم کرد.

chatgpt جواب اشتباه زیر را داد:

وی گفت: “تکنیک ماهیگیری موازی توله سگ برای باس راه راه ، یک روش تخصصی ریخته گری و بازیابی است که اغلب هنگام هدف قرار دادن باس راه راه در آب کم عمق در نزدیکی سازه ساحلی مانند اسکله ها ، بانک های سود یا نقاط صخره ای استفاده می شود.

در اینجا تفکیک آنچه که معمولاً شامل می شود آورده شده است:

چیست:

“موازی” به ریختن فریب یا طعمه شما به موازات خط ساحلی ، به جای اینکه در آب عمیق تر باشد ، اشاره دارد.“توله سگ” اغلب نام مستعار پلاستیک های کوچک نرم ، شنا یا شاخه های کوچک است ، به طور معمول در محدوده 3 تا 5 ″-رنگ آمیزی طعمه های نوجوان.

این جمله آخر جالب است زیرا کاملاً اشتباه است ، هیچ سبک فریبنده ای وجود ندارد که نام مستعار “توله سگ” باشد اما تکنیکی به نام پیاده روی سگ وجود دارد. “

تصویر پاسخ نادرست Chatgpt

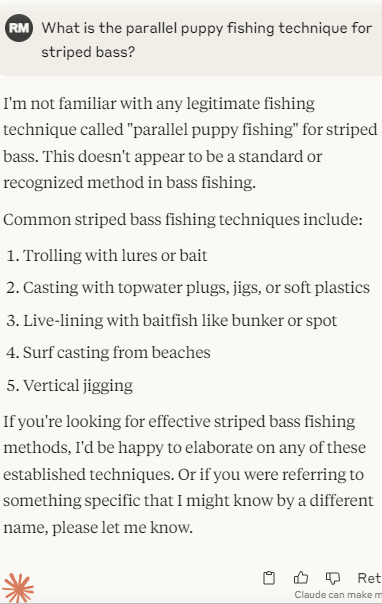

کلود

Claude Anthropic ، با استفاده از آخرین مدل 3.7 غزل ، پاسخ صحیحی ارائه داد. به درستی گفت که این یک “تکنیک ماهیگیری مشروع” را با نام ارائه شده تشخیص نمی دهد و سپس با این پیش فرض حرکت می کند که کاربر می خواهد تاکتیک های ماهیگیری باس راه راه را یاد بگیرد و لیستی از تکنیک هایی را ارائه می دهد که کاربر می تواند یک موضوع را به عنوان یک سؤال پیگیری انتخاب کند.

تصویر پاسخ صحیح کلود انسان شناسی

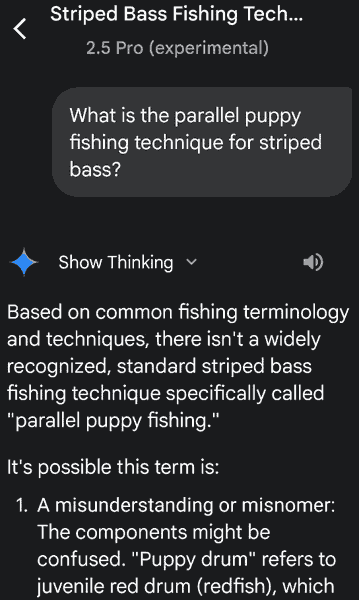

Google Gemini Pro 2.5

سرانجام با استفاده از آخرین مدل Pro 2.5 ، Google Gemini را پرسیدم. جمینی همچنین یک پاسخ صحیح به علاوه خروجی درخت تصمیم گیری ارائه داد که کاربر را قادر به تصمیم گیری می کند:

الف) اینکه آنها در حال درک تاکتیک های ماهیگیری هستند

ب – مراجعه به یک تاکتیک بسیار بومی

ج. در حال ترکیب چندین تاکتیک ماهیگیری است

د. یا یک تاکتیک برای گونه دیگری از ماهی گیج کننده است.

تصویر از پاسخ صحیح Gemini Pro 2.5

آنچه در مورد آن درخت تصمیم گیری جالب است ، که شبیه رویکرد درخت تصمیم در ثبت اختراع Google نامربوط است ، این است که این امکانات به نوعی منعکس کننده آنچه در زمینه های هوش مصنوعی Google ممکن است LLM و Chatgpt در تلاش برای پاسخ به این سوال در نظر گرفته باشند. هر دو آنها ممکن است از یک درخت تصمیم و گزینه C انتخاب شده اند که کاربر در حال ترکیب تاکتیک های ماهیگیری است و پاسخ های خود را بر اساس آن بنا می کند.

Claude و Gemini هر دو به اندازه کافی اطمینان داشتند که گزینه E را انتخاب کنند ، که کاربر نمی داند در مورد چه چیزی صحبت می کند و به یک درخت تصمیم گیری متوسل شده است تا کاربر را به انتخاب پاسخ درست راهنمایی کند.

این در مورد نمای کلی AI (AIO) چه معنی دارد؟

گوگل به تازگی اعلام کرده است که Gemini 2.0 را برای نمایش داده های پیشرفته ریاضی ، برنامه نویسی و چند حالته در حال چرخش است اما توهم در AIO نشان می دهد که مدل Google برای پاسخ به نمایش داده های متن ممکن است نسبت به Gemini 2.5 پایین باشد.

این احتمالاً همان چیزی است که با نمایش داده های جیب زده اتفاق می افتد و همانطور که گفتم ، بینش جالبی از نحوه عملکرد Google AIO ارائه می دهد.

تصویر برجسته توسط Shutterstock/Slladkaya